来源:量子位

从Meta的LLaMA发展出的羊驼家族一系列大模型,已成为开源AI重要力量y-disk苹果版。

但LLamA开源了又没全开,只能用于研究用途,还得填申请表格等,也一直被业界诟病y-disk苹果版。

好消息是,两大对标LLaMA的完全开源项目同时有了新进展y-disk苹果版。

可商用开源大模型来了y-disk苹果版,还一下来了俩:

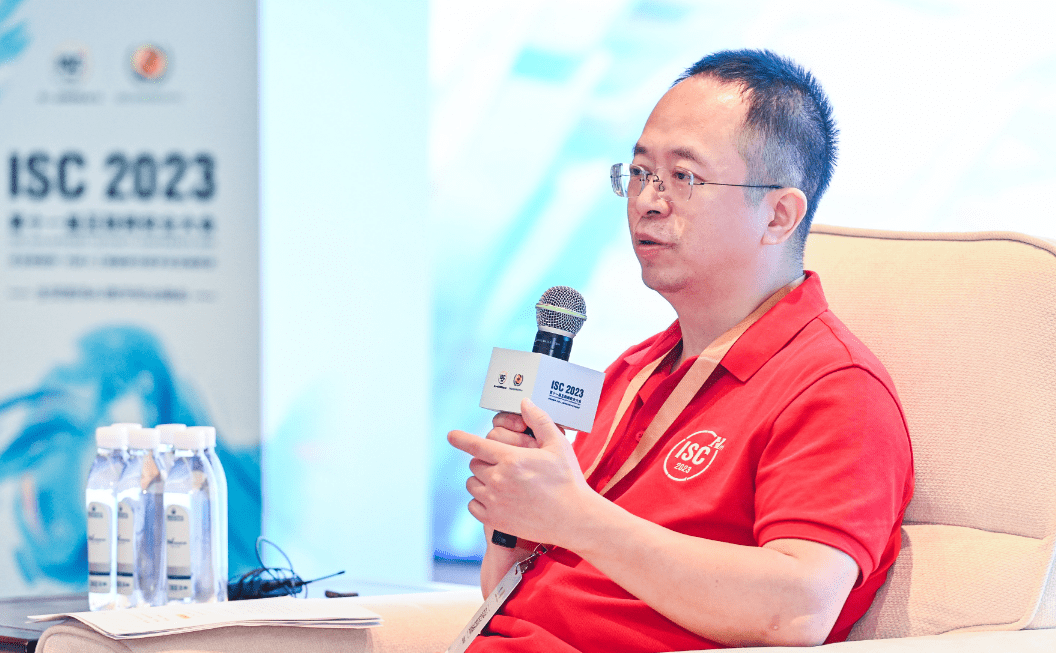

MosaicML推出MPT系列模型,其中70亿参数版在性能测试中与LLaMA打个平手y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

Together的RedPajama(红睡衣)系列模型,30亿参数版在RTX2070游戏显卡上就能跑y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

对于这些进展,特斯拉前AI主管Andrej Karpathy认为,开源大模型生态有了寒武纪大爆发的早期迹象y-disk苹果版。

展开全文

MPTy-disk苹果版,与LLaMA五五开

MPT系列模型,全称MosaicML Pretrained Transformer,基础版本为70亿参数y-disk苹果版。

MPT在大量数据(1T tokens)上训练,与LLaMA相当,高于StableLM,Pythia等其他开源模型y-disk苹果版。

支持84k tokens超长输入,并用FlashAttention和FasterTransformer方法针对训练和推理速度做过优化y-disk苹果版。

在各类性能评估中,与原版LLaMA不相上下y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

除了MPT-7B Base基础模型外还有三个变体y-disk苹果版。

MPT-7B-Instruct,用于遵循简短指令y-disk苹果版。

MPT-7B-Chat,用于多轮聊天对话y-disk苹果版。

MPT-7B-StoryWriter-65k+,用于阅读和编写故事,支持65k tokens的超长上下文,用小说数据集微调y-disk苹果版。

MosaicML由前英特尔AI芯片项目Nervana负责人Naveen Rao创办y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

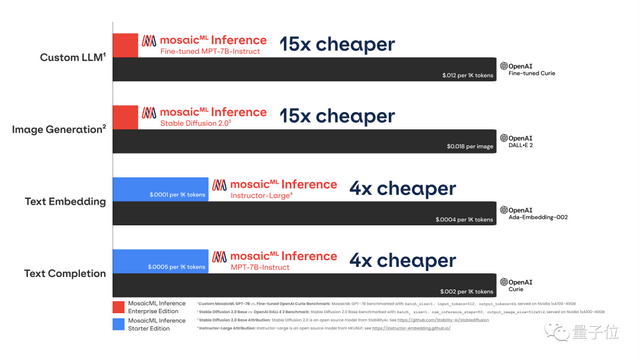

该公司致力于降低训练神经网络的成本,推出的文本和图像生成推理服务成本只有OpenAI的1/15y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

RedPajamay-disk苹果版,2070就能跑

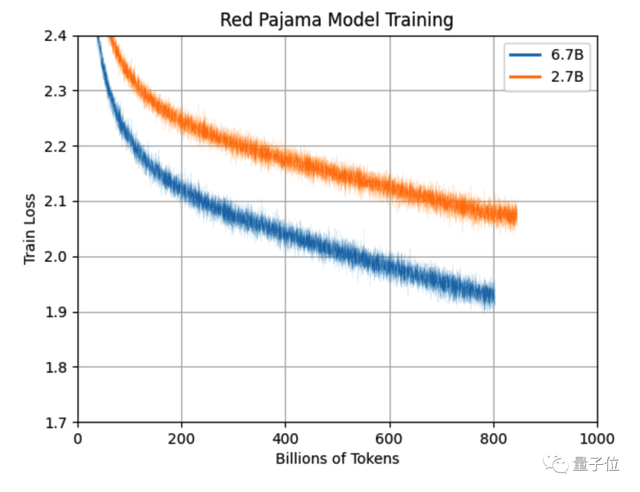

RedPajama系列模型,在5TB的同名开源数据上训练而来(前面提到的MPT也是用此数据集训练)y-disk苹果版。

除70亿参数基础模型外,还有一个30亿参数版本,可以在5年前发售的RTX2070游戏显卡上运行y-disk苹果版。

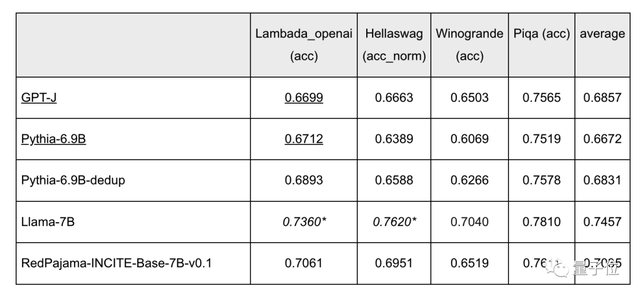

目前70亿版本完成了80%的训练,效果已经超过了同规模的Pythia等开源模型,略逊于LLamAy-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

预计在完成1T tokens的训练后还能继续改进y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

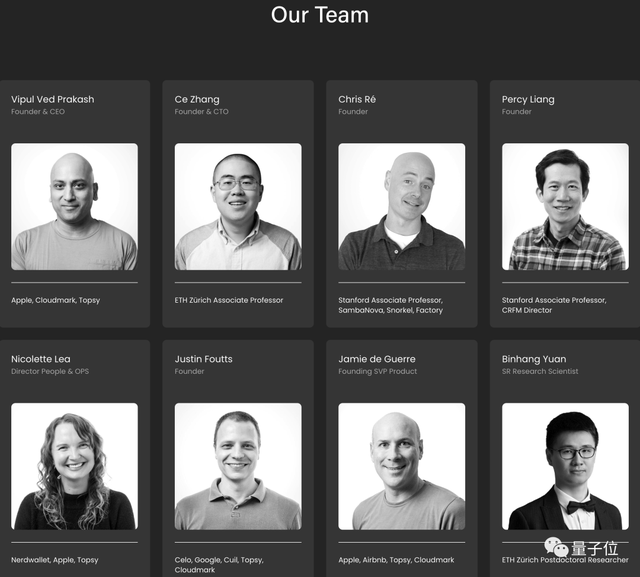

背后公司Together,由苹果前高管Vipul Ved Prakash,斯坦福大模型研究中心主任Percy Liang,苏黎世联邦理工大学助理教授张策等人联合创办y-disk苹果版。

开源模型发布后,他们的近期目标是继续扩展开源RedPajama数据集到两倍规模y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

One More Thing

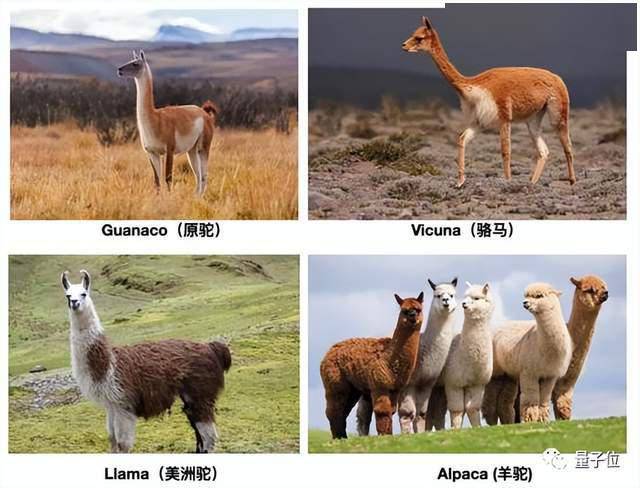

来自南美洲的无峰驼类动物一共4种,已被各家大模型用完了y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

Meta发布LLaMA之后,斯坦福用了Alpaca,伯克利等单位用了Alpaca,Joseph Cheung等开发者团队用了Guanacoy-disk苹果版。

以至于后来者已经卷到了其他相近动物,比如IBM的单峰骆驼Dromedary,Databricks的Dolly来自克隆羊多莉y-disk苹果版。

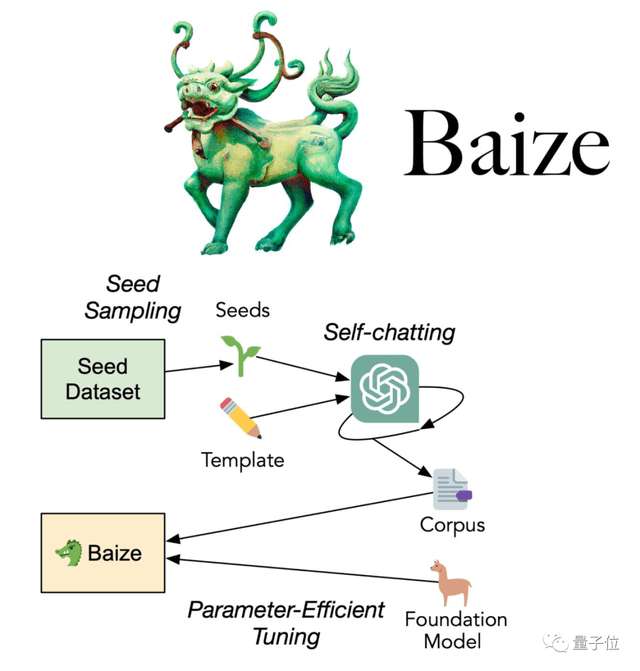

国人研究团队也热衷于用古代传说中的神兽,如UCSD联合中山大学等推出的白泽y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

港中文等推出的凤凰……

y-disk苹果版,羊驼家族名字都不够用了" >

最绝的是哈工大基于中文医学知识的LLaMA微调模型,命名为华驼y-disk苹果版。

y-disk苹果版,羊驼家族名字都不够用了" >

参考链接: